Hadoop实验2:HDFS操作

Hadoop实验2:HDFS操作

实验2:HDFS操作

1 启动Docker和Hadoop服务

首先按照顺序启动四个Docker容器

1

2

3

4

docker start master

docker start slave1

docker start slave2

docker start slave3

接着使用以下命令,进入到master环境内:

1

docker exec -it --privileged master /bin/bash

然后在master容器内启动Hadoop服务

1

2

3

start-dfs.sh

start-yarn.sh

mr-jobhistory-daemon.sh start historyserver

2 HDFS 完整命令概览

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

hadoop fs [generic options] [-appendToFile <localsrc> ... <dst>]

[-cat [-ignoreCrc] <src> ...]

[-checksum <src> ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>]

[-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-count [-q] [-h] <path> ...]

[-cp [-f] [-p | -p[topax]] <src> ... <dst>]

[-createSnapshot <snapshotDir> [<snapshotName>]]

[-deleteSnapshot <snapshotDir> <snapshotName>]

[-df [-h] [<path> ...]]

[-du [-s] [-h] <path> ...]

[-expunge]

[-find <path> ... <expression> ...]

[-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-getfacl [-R] <path>]

[-getfattr [-R] {-n name | -d} [-e en] <path>]

[-getmerge [-nl] <src> <localdst>]

[-help [cmd ...]]

[-ls [-d] [-h] [-R] [<path> ...]]

[-mkdir [-p] <path> ...]

[-moveFromLocal <localsrc> ... <dst>]

[-moveToLocal <src> <localdst>]

[-mv <src> ... <dst>]

[-put [-f] [-p] [-l] <localsrc> ... <dst>]

[-renameSnapshot <snapshotDir> <oldName> <newName>]

[-rm [-f] [-r|-R] [-skipTrash] <src> ...]

[-rmdir [--ignore-fail-on-non-empty] <dir> ...]

[-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]]

[-setfattr {-n name [-v value] | -x name} <path>]

[-setrep [-R] [-w] <rep> <path> ...]

[-stat [format] <path> ...]

[-tail [-f] <file>]

[-test -[defsz] <path>]

[-text [-ignoreCrc] <src> ...]

[-touchz <path> ...]

[-truncate [-w] <length> <path> ...]

[-usage [cmd ...]]

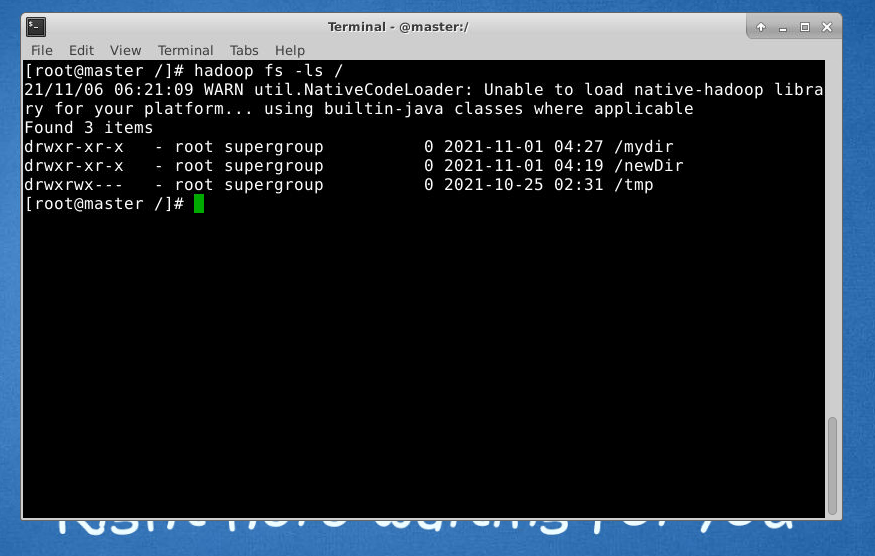

3 查看、创建与删除目录

3.1 查看目录

命令使用格式:hadoop fs -ls 目录名

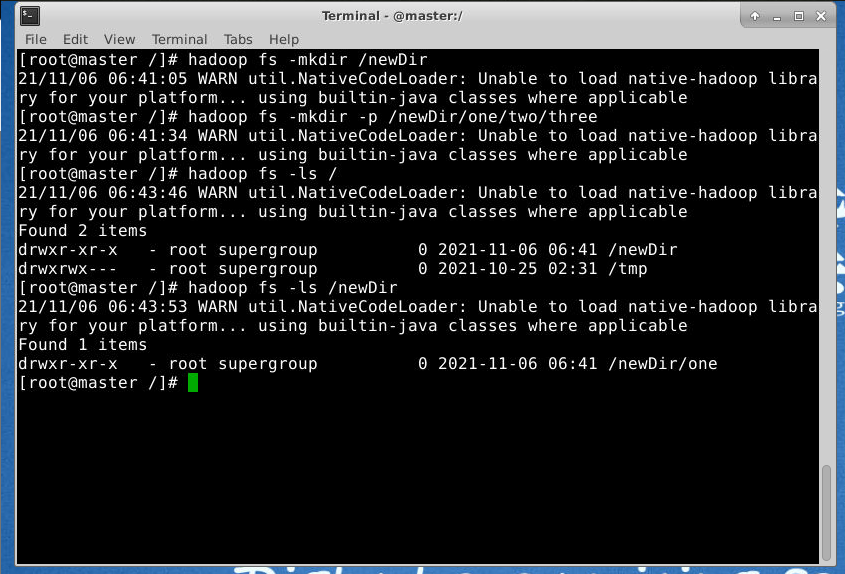

3.2 创建目录

使用格式:hadoop fs -mkdir 目录名

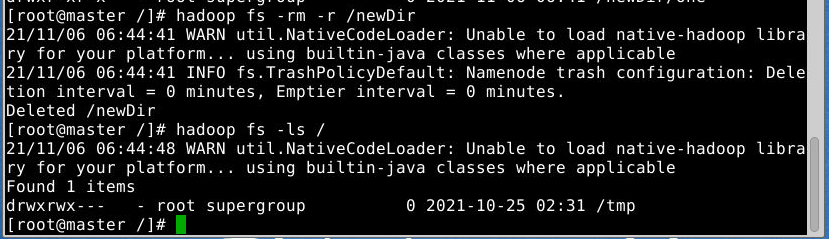

3.3 删除目录

使用格式:hadoop fs -rm -r 目录名

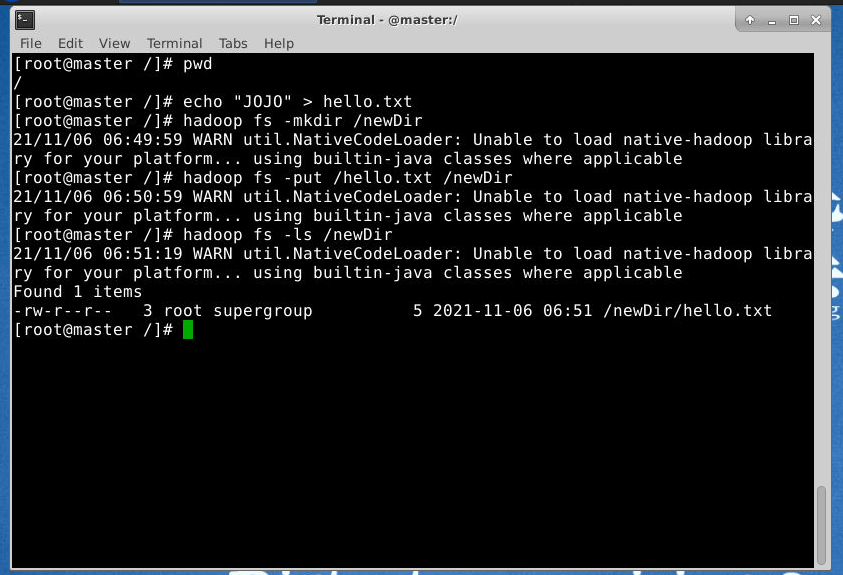

4 文件的基本操作

4.1 文件上传

使用格式:hadoop fs -put 本地文件路径 HDFS文件路径

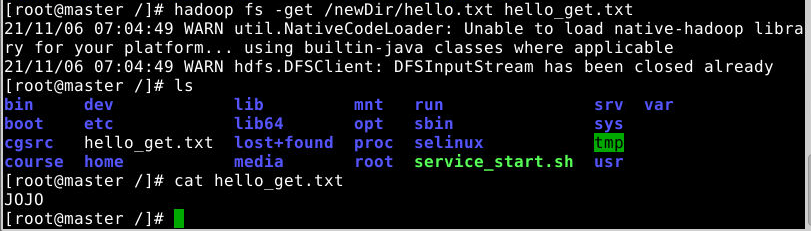

4.2 文件下载

使用格式:hadoop fs -get HDFS文件路径 本地文件路径

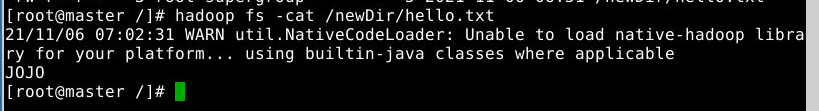

4.3 查看文件内容

使用格式:hadoop fs -cat 文件路径

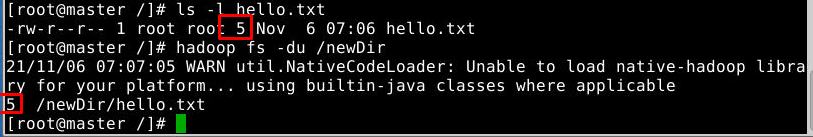

4.4 查看文件大小

使用格式:hadoop fs -du 参数 目录或文件

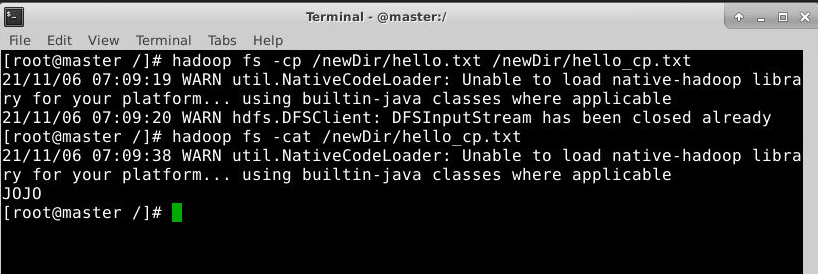

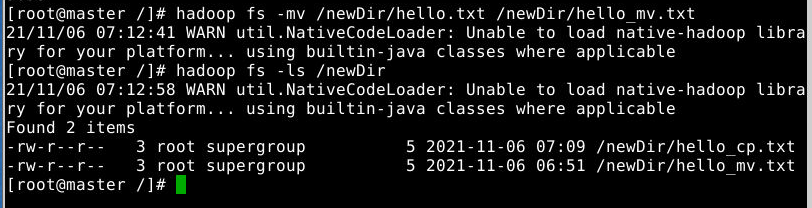

4.5 复制文件

使用格式:hadoop fs -cp 文件名 复制后的文件名

4.6 重命名/移动文件

使用格式:hadoop fs -mv 目录或文件 目录

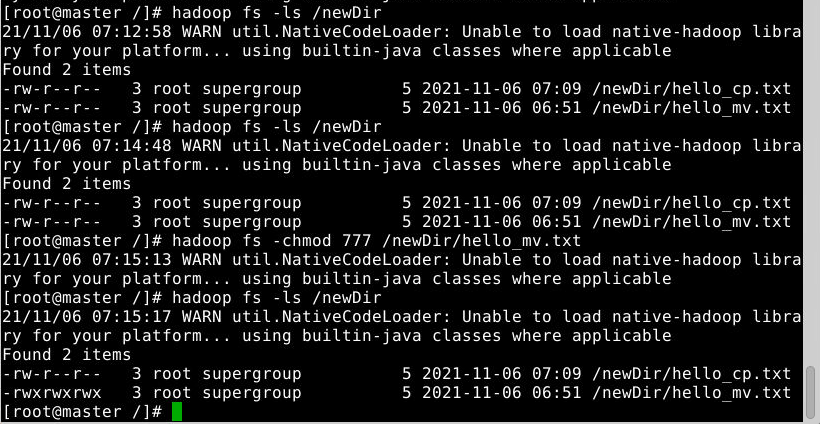

4.7 文件权限修改

使用格式:hadoop fs -chmod 权限选项 目录或者文件

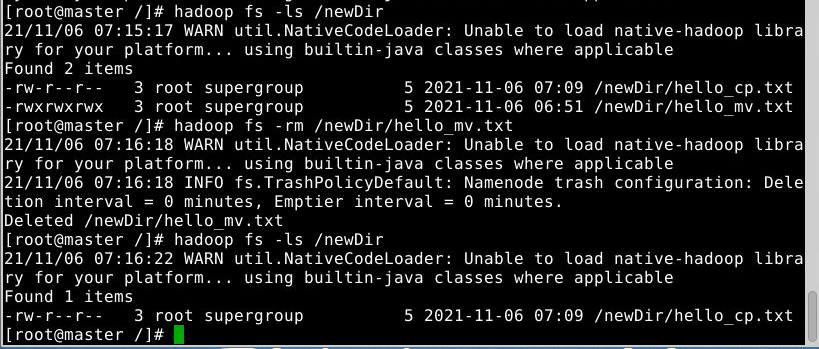

4.8 删除文件

使用格式:hadoop fs -rm 文件路径

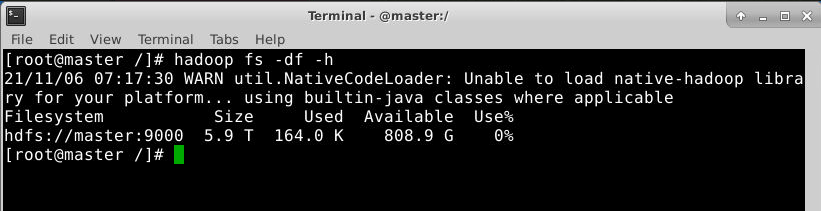

5 查看文件系统信息

5.1 查看文件系统信息

本文由作者按照 CC BY 4.0 进行授权